随着人工智能(AI)技术的飞速发展,AI服务器作为支撑AI计算的重要基础设施,正变得越来越重要。AI服务器是指专门为运行AI工作负载而优化设计的服务器,它们配备了强大的处理器、高速内存以及高效能的存储系统,确保能够处理大量的数据和复杂的算法计算。本文将详细介绍AI服务器的概念、类型以及它们在实际应用中的特点。

什么是AI服务器?

AI服务器是高性能服务器的一种,它们具备执行深度学习、机器学习等AI算法所需的硬件资源和软件支持。AI服务器的主要特点包括搭载高性能的中央处理单元(CPU)、图形处理单元(GPU)、张量处理单元(TPU)或其他专用AI加速器,以及高速的内存和存储解决方案。这些特性使得AI服务器能够高效地进行并行计算,满足AI模型训练和推理的需求。

AI服务器的类型

AI服务器按照其硬件配置和应用场景可以分为几种类型:

1.CPU型AI服务器:以强大的CPU作为主要计算单元,适用于需要大量数据处理但对并行计算需求不是特别高的AI应用。

2.GPU型AI服务器:主要搭载GPU加速器,适用于深度学习模型训练,能够处理大规模并行计算任务,是目前AI服务器中最常见的类型。

3.TPU型AI服务器:谷歌推出的张量处理单元(TPU)是专门为AI计算设计的芯片,相较于传统CPU和GPU,在特定AI计算任务上能提供更高的性能和能效。

4.FPGA型AI服务器:现场可编程门阵列(FPGA)能够被定制化编程以执行特定的算法,它们在AI领域内的推理任务中表现优异,灵活性和能效比都较高。

5.混合型AI服务器:结合了CPU、GPU、FPGA等多种计算单元,适用于复杂多变的AI应用,能够提供更全面的计算能力和更高的资源利用率。

AI服务器在实际应用中的特点

AI服务器在实际应用中具有以下显著特点:

高效并行计算能力:AI服务器能够同时处理大量数据和复杂计算,显著缩短AI模型的训练和推理时间。

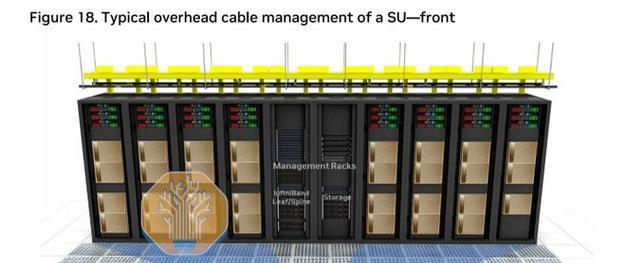

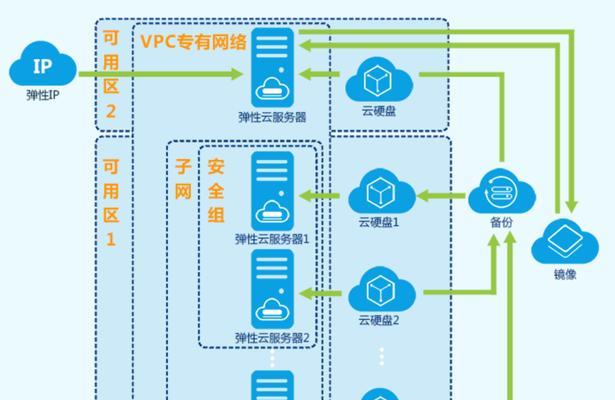

灵活的可扩展性:随着AI项目的扩展,AI服务器可以通过增加更多计算单元或存储资源来应对更高的计算需求。

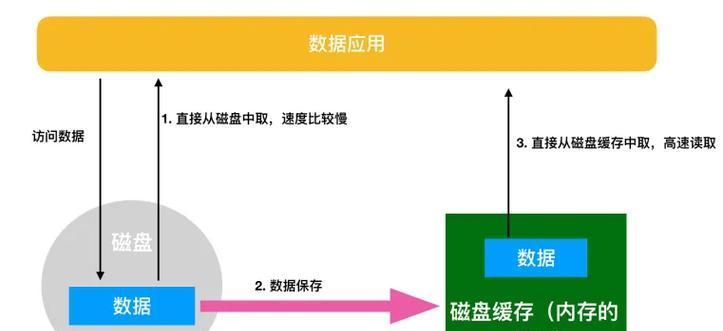

优化的系统架构:为了适应AI计算需求,AI服务器采用了优化的数据传输和存储架构,提高数据处理速度和效率。

专用的AI软件支持:与AI服务器硬件相匹配的软件堆栈,包括深度学习框架、AI算法库等,能够充分利用硬件资源进行AI计算。

节能和低延迟:AI服务器通常具备良好的能效比,能够减少能源消耗,同时硬件加速器如GPU和TPU等能够降低延迟,提高响应速度。

结语

AI服务器作为支持人工智能发展的核心硬件,其多样化的类型和强大的功能特点使其在各类AI应用中扮演着至关重要的角色。无论是从商业智能分析到自动驾驶技术,还是从医疗影像处理到语音识别领域,AI服务器都提供了强大的计算支持,加速了AI技术的普及和应用。随着技术的不断进步,我们可以期待AI服务器在未来的应用中展现出更加惊人的潜力。